-

[AI] 신경망 학습(밑바닥부터 시작하는 딥러닝)💻Programming/AI 2023. 12. 18. 20:23

신경망의 가중치 매개변수의 값을 데이터를 보고 자동으로 결정한다. 아주 큰 장점이다.

🔗 데이터 주도 학습

학습: 훈련 데이터로부터 가중치 매개변수의 최적값을 자동으로 획득하는 것

기계학습

1. 데이터에서 답을 찾고 데이터에서 패턴을 발견하고 데이터로 이야기를 만듦

2. 사람의 개입을 최소화하고 수집한 데이터로부터 패턴을 찾으려 시도

📍 종단간 기계학습(end-to-end machine learning)

기계학습: 데이터의 특징을 벡터로 변환하는 것은 '사람이' 설계

딥러닝: 데이터 입력에서 목표한 결과를 사람의 개입 없이 얻음.

두 번째 접근 방식에서는 사람이 특징을 사람이 설계했지만, 신경망은 이미지에 포함된 중요한 특징까지도 '기계'가 스스로 학습할 것이다.

이렇게 딥러닝은 처음부터 끝까지 데이터(입력)에서 목표한 결과(출력)을 사람의 개입 없이 얻을 수 있다는 점에서 처음부터 끝까지라는 의미를 가진 종단간 기계학습이라고도 불린다.

🔗 훈련 데이터와 시험 데이터

- 훈련 데이터(trainig data): 최적의 매개변수를 탐색하는데 사용

- 시험 데이터(test data): 훈련한 모델의 성능을 평가하는데 사용

- 왜 훈련 데이터와 시험 데이터를 나누는가?: 모델의 "범용 능력(=훈련 데이터가 아닌 데이터로도 문제를 올바르게 풀어내는 능력)"을 제대로 평가하기 위해

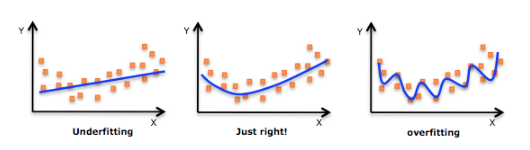

- 오버피팅(overfitting): 한 데이터셋에만 지나치게 최적화된 상태

왼쪽은 과소 적합(언더피팅)의 예시이고, 오른쪽은 과대 적합(오버피팅)의 예시이다.

🔗 손실 함수(loss function)

손실 함수는 신경망 성능의 '나쁨'을 나타내는 지표로, 현재의 신경망이 훈련 데이터를 얼마나 잘 처리하지 '못하느냐'를 기준으로 한다.

평균 제곱 오차와 교차 엔트로피 오차를 일반적으로 사용

📍 평균 제곱 오차(Mean Squared Error, MSE)

평균 제곱 오차 수식 ✨ 평균 제곱 오차 구현

def mean_squared_error(y, t): return 0.5 * np.sum((y-t)**2)✨ 원-핫 인코딩

데이터를 쉽게 중복 없이 표현할 때 사용하는 형식

1. 각 단어에 고유한 인덱스 부여

2. 표현하고 싶은 단어의 인덱스 위치에 1을 부여, 다른 단어의 인덱스 위치에는 0을 부여

단점: 단어가 많으면 인덱스가 길어진다 / 불필요한 공간을 차지하는 경우가 많아진다.

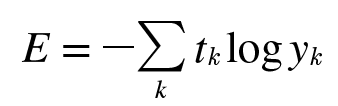

📍 교차 엔트로피 오차(Cross Entropy Error, CEE)

교차 엔트로피 오차 수식 y는 신경망의 출력, t는 정답 레이블로 t는 정답에 해당하는 인덱스의 원소만 1이고 나머지는 0(원-핫 인코딩). 그래서 이 수식은 실질적으로 정답일 때의 자연 로그를 계산하는 식이 된다. 교차 엔트로피 오차는 정답일 때의 출력이 전체 값을 정하게 된다.

✨ 교차 엔트로피 오차의 구현

def cross_entropy_error(y, t): delta = 1e-7 return -np.sum(t * np.log(y+delta))

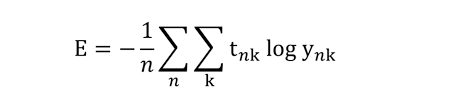

🔗 미니 배치 학습

기계학습 문제는 훈련 데이터를 사용해 학습한다. 구체적으로 말하면 훈련 데이터에 대한 손실 함수의 값을 구하고, 그 값을 최대한 줄여주는 매개변수를 찾아낸다. 이렇게 하기 위해선 모든 훈련 데이터를 대상으로 손실 함수 값을 구해야 한다.

모든 데이터에 대한 손실함수의 값의 합을 구하는 수식 위의 교차 엔트로피 오차를 이용하여 모든 훈련 데이터에 대한 손실함수의 값을 구해 평균을 내는 수식이다.

이렇게 되면 훈련 데이터가 1000개이던지 10000개이던지 평균 손실 함수를 구할 수 있다. 하지만 실제 사용되는 빅데이터는 그 수는 수백만에서 수천만이 넘는 거대한 값이 되기도 하는데, 이 많은 데이터를 대상으로 일일이 손실 함수를 계산하는 것은 굉장히 오랜 시간이 걸릴 것이다. 그래서 나온 개념이 미니배치이다.

✨ 미니 배치

데이터 일부를 추려 전체의 '근사치'로 이용할 수 있다. 이 일부를 '미니배치'라고 한다. 예를 들어 60000장의 훈련 데이터 중에서 100장을 무작위로 뽑아 100장만을 사용하여 학습하는 것을 미니배치 학습이라고 한다.

✨ (배치용) 교차 엔트로피 오차 구현하기

# 정답 레이블이 원-핫 인코딩인 경우 def cross_entropy_error(y, t): if y.ndim == 1: # y가 1차원이라면, 데이터 하나당 교차 엔트로피 오차를 구하는 경우 reshape 함수로 데이터의 형상을 바꿔줌 t = t.reshape(1, t.size) y = y.reshape(1, y.size) batch_size = y.shape[0] return -np.sum(t * np.log(y + 1e-7)) / batch_size # 정답 레이블이 숫자 레이블로 주어진 경우 def cross_entropy_error(y, t): if y.ndim == 1: t = t.reshape(1, t.size) y = y.reshape(1, y.size) batch_size = y.shape[0] return -np.sum(np.log(y[np.arrange(batch_size), t] + 1e-7)) / batch_size

🔗 왜 손실 함수를 설정하는가?

우리의 목적은 높은 "정확도"를 끌어내는 매개변수 값을 찾는 것인데, 왜 정확도라는 지표 대신에 손실 함수의 값이라는 지표를 택하는 것일까? -> 신경망 학습에서의 미분의 역할에 주목

신경망 학습에서는 최적의 매개변수를 탐색할 때 손실 함수의 값을 가능한 작게 하는 매개변수 값을 찾는다. 이 때 매개변수의 미분값을 계산하고, 그 미분값을 단서로 매개변수를 갱신하는 과정을 반복한다. 만약 미분값이 음수이면 그 매개변수를 양의 방향으로 변화시켜 손실 함수의 값을 줄일 수 있다. 반대로 양수이면 음의 방향으로 변화시켜 손실함수의 값을 줄일 수 있다. 하지만 미분값이 0이면 가중치 매개변수를 어느쪽으로 움직여도 손실함수의 값은 달라지지 않기 때문에 가중치 매개변수의 갱신은 거기서 멈추게 된다.

정확도를 지표로 삼으면 안되는 이유는 미분 값이 대부분의 장소에서 0이 되어 매개변수를 갱신할 수 없기 때문.

정확도가 개선된다고 하더라도 불연속적인 값으로 변함.

예: 100장의 훈련 데이터 중 32장을 맞춘 신경망이 있다고 한다면, 가중치를 변경해 정확도를 높이더라도 34, 35%등 불연속적으로 변함. 손실함수의 경우 매개변수가 주는 작은 변화가 주는 파장을 잡을 수 있다.

🔗 수치 미분

- 수치 미분: 함수의 특정 점에서의 기울기를 근사적으로 계산하는 방법

- 미분: '특정 순간'의 변화량

- 중심 차분: x를 중심으로 그 전후의 차분 계산 (x+h) - (x-h)

- 전방 차분: (x+h) - (x)

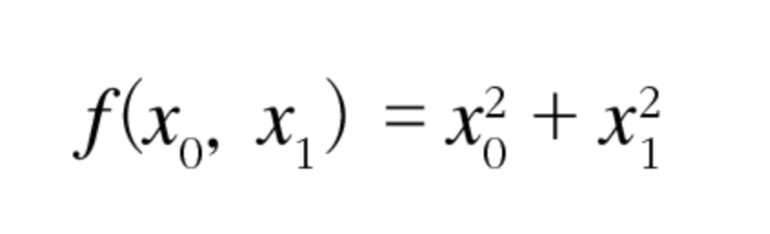

- 편미분: 변수가 여럿인 함수에 대한 미분

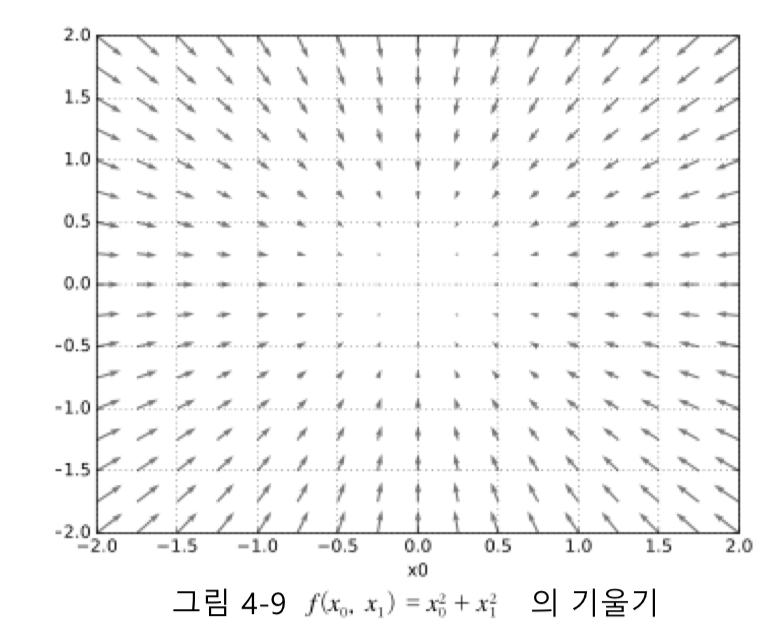

변수가 여럿인 함수 - 기울기: 모든 변수의 편미분을 벡터로 정리한 것

위의 식의 기울기 기울기가 가리키는 쪽은 각 장소에서 함수의 출력값을 가장 크게 줄이는 방향이다.

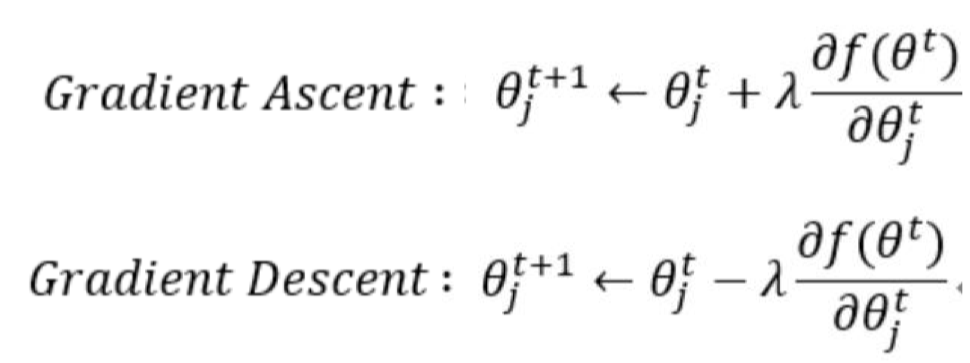

🔗 경사하강법(Gradient Descent Method)

매개변수 공간이 광대하여 어디가 최소값이 되는 곳인지 짐작할 수 없을 때, "기울기"를 이용해 손실 함수의 최소값을 찾으려는 것

✨ 학습률(learning rate)

한 번의 학습으로 얼마만큼 학습해야 할지, 매개변수 값을 얼마나 갱신해야 할 지를 정하는 것

너무 크면 큰 값으로 발산하거나 Oscillation(진동)을 수행하며 수렴되지 않는다.

너무 작으면, 거의 갱신되지 않은 채 수렴이 끝난다.

✨ 하이퍼파라미터(hyper parameter)

학습률과 같이 사람이 직접 설정해야 하는 매개변수로 실험적으로 반복을 통해 찾아낸다.

경사법 수식 최적(Optimization): 손실 함수 값이 최소값이 될 때의 매개변수 값

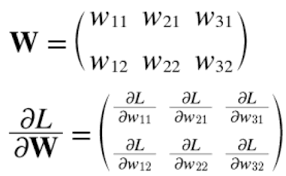

📍 신경망에서의 기울기

가중치 매개변수에 대한 손실 함수의 기울기

가중치 매개변수의 형상과 가중치 매개변수에 대한 손실함수의 형상은 같다.

🔗 학습 알고리즘 구현하기

✨ 전제

신경망에는 적응 가능한 가중치와 편향이 있고, 이 가중치와 편향을 훈련 데이터에 적용하도록 조정하는 과정을 '학습'이라고 한다.

✨ 1단계: 미니배치

훈련 데이터 중 일부를 무작위로 가져옴. 이렇게 선별한 데이터를 미니배치라 하며, 그 미니배치의 손실함수 값을 줄이는 것이 목표

✨ 2단계: 기울기 산출

미니배치의 손실 함수 값을 줄이기 위해 각 가중치 매개변수의 기울기를 구함. 기울기는 손실 함수의 값을 가장 작게 하는 방향을 제시함.

✨ 3단계: 매개변수 갱신

가중치 매개변수를 기울기 방향으로 아주 조금 갱신

✨ 4단계: 1~3단계를 반복

모든 데이터가 소진될 때까지 반복적으로 미니배치를 사용하여 모델을 업데이트

이것이 경사 하강법으로 매개변수를 갱신하는 방법이며, 이 때 데이터를 미니배치로 무작위로 선정하기 때문에 확률적 경사 하강법(Stochastic Gradient Descent, SGD)라고 부른다. 대부분의 딥러닝 프레임워크는 확률적 경사 하강법의 머리글자를 딴 SGD라는 함수로 이 기능 구현.

에폭(epoch): 학습에서 훈련 데이터를 모두 소진했을 떄의 횟수

미니배치 학습에서 배치 크기와 에폭을 하이퍼 파라미터로 줄 수 있다.

예: 훈련 데이터 10000개를 100개의 미니배치로 학습할 경우, 확률적 경사 하강법을 100회 반복하면 모든 훈련 데이터를 소진하게 되며, 이 경우 100회가 1 에폭이 된다.

🔗 정리

1. 기계학습에서 사용하는 데이터셋은 훈련 데이터와 시험 데이터로 나눠 사용

2. 훈련 데이터로 학습한 모델의 범용 능력을 시험 데이터로 평가

3. 신경망 학습은 손실 함수를 지표로, 손실 함수의 값이 작아지는 방향으로 가중치 매개변수를 갱신

4. 가중치 매개변수를 갱신할 때는 가중치 매개변수의 기울기를 이용하고, 기울어진 방향으로 가중치의 값을 갱신하는 작업을 반복

5. 아주 작은 값을 주었을 때의 차분으로 미분하는 것을 수치 미분이라 하고, 수치 미분을 이용해 가중치 매개변수의 기울기를 구할 수 있다.

'💻Programming > AI' 카테고리의 다른 글

[AI] 오차역전파법(밑바닥부터 시작하는 딥러닝) (0) 2023.12.18 [AI] 신경망과 활성화함수 / 행렬의 곱 / 신경망의 구현(밑바닥부터 시작하는 딥러닝) (1) 2023.12.17 [AI] 퍼셉트론과 퍼셉트론의 구현 / 퍼셉트론의 한계 (밑바닥부터 시작하는 딥러닝) (0) 2023.12.16 [AI] 경사하강법(feat: 최적화, 손실 함수) - 선형 회귀 분석(2) with Python(밑바닥부터 시작하는 딥러닝) (1) 2023.12.15 [AI] 퍼셉트론과 활성화 함수 (0) 2023.10.31