-

[AI] 경사하강법(feat: 최적화, 손실 함수) - 선형 회귀 분석(1)💻Programming/AI 2023. 10. 17. 16:27

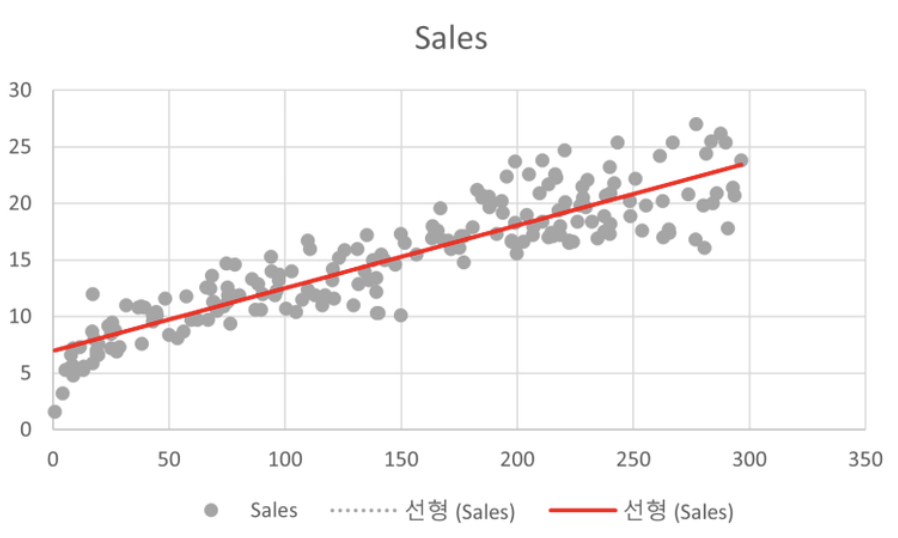

🔗 선형 회귀 분석이란?

- 딥러닝 알고리즘 학습 시 사용 되는 “최적화 방법” 중 하나로 ,

- 주어진 데이터들을 가장 잘 설명하는 “직선” 하나를 찾는 것. = 딥러닝 알고리즘 학습 시 목표는 예측값과 정답값 간의 차이인 손실함수의 크기를 최소화시키는 파라미터를 찾는 것

- 단순 선형 회귀: 하나의 독립변수에 대해 선형회귀분석을 하는 것.

- 예: y=wx+b. 키에 따라 몸무게가 달라짐(키-독립변수, 몸무게-종속변수) -> 이 식을 구한다면, 일반적인 사람의 키에 따른 몸무게를 예측할 수 있다.

- 위의 식에서 w와 b는 Weight와 Bias로 가중치와 편향을 의미한다.

- 다중 선형 회귀: 독립변수가 여러 개인 경우에 대해 선형 회귀 분석을 하는 것.

- 선형 회귀를 통해서 “변수간의 상관관계”를 알 수 있다.

- 선형 회귀를 알기 전에 최적화와 손실 함수의 개념에 대해서 알아야 한다.

🔗 최적화(Optimization)란?

- 인공지능에서 신경망이 학습할 때 최적의 파라미터를 찾아가는 방식 <- 선형 회귀 방식에서는 이 파라미터가 w와 b 즉, 가중치와 편향이다. 적절한 가중치와 편향을 찾아가는 과정이 최적화

- 모델의 예측값과 실제 값의 차이를 오차(=error, loss)라고 하며 이 오차를 줄이기 위해 예측 값이 실제 값과 얼마나 유사한지 판단하는 기준이 손실함수(Loss Function)이다. -> 최적화를 위해 손실 함수가 필요.

🔗 손실 함수(Loss Function)

- 모델의 예측값과 실제 값의 차이를 loss라고 하는데, 이것을 함수로 나타낼 수 있고, 그 함수를 손실 함수라고 한다. 우리는 이 손실 함수의 값을 줄이는 방향으로 학습을 진행한다.

- 손실함수의 종류는 여러개가 있다. 그 중에 많이 사용 되는 두 가지를 알아보자!

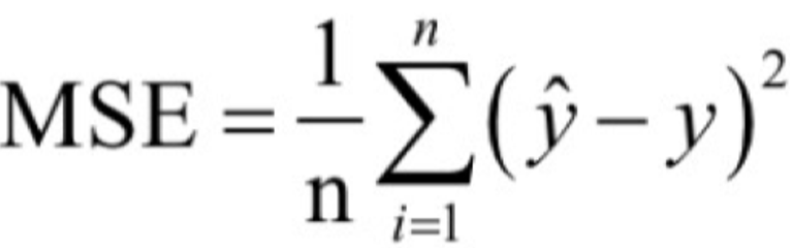

📍 평균 제곱 오차(MSE, Mean Squared Error)

- 예측값과 실제 값을 뺀 값들을 각각 제곱하여 평균을 계산

- 제곱을 함으로써 ‘부호’를 없애준다. → 차이 값이 양수이던지 음수이던지 오차는 오차인데, 그 차이들이 더해지면서 상쇄되는 경우를 방지하기 위함.

- n: 데이터 개수

- y: 주어진 데이터의 값

- ŷ: 예측값

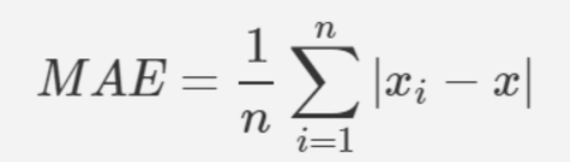

📍 평균 절대 오차(MAE, Mean Absolute Error)

- 평균 절대 오차는 모든 절대 오차의 평균

📍 MSE vs MAE

- 절댓값 연산이 기울기 계산에 있어 단순 곱 연산에 비해 오랜 시간이 걸린다.

- MSE 함수는 제곱을 하게 됨으로 오류가 강조됨.

- 실제로는 MSE가 더 많이 사용됨.

🔗 경사 하강법(Gradient Descent)을 통한 최적화

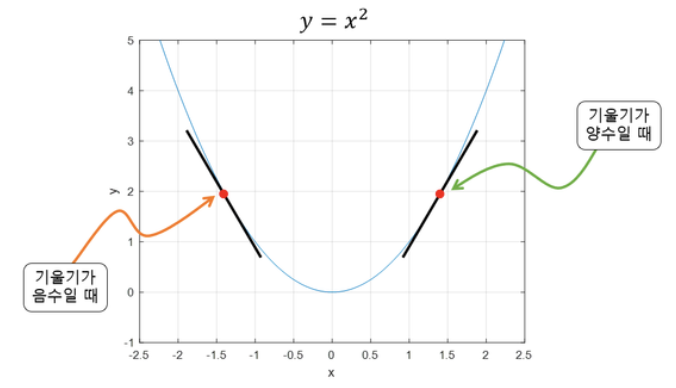

📍경사 하강법이란?

- 오차 함수의 값이 최소인 지점에 가까워질수록 기울기는 점점 작아지는 것을 이용하여 기울기를 점점 줄여나가면서 최종적으로 오차를 최소화하는 기울기로 수렴하게 되면서 오차를 최소화하는 최적의 기울기를 찾는 최적화 방법이다.

- 함수의 최솟값을 찾는 문제에서 이용

- 미분 계수가 0인 지점을 찾지 않고 굳이 경사하강법을 사용하는 이유

- 함수가 닫힌 형태가 아닌 경우

- 함수가 너무 복잡해 미분 계수를 구하기 어려운 경우

- Gradient Descent를 구현하는게 미분 계수를 구하는 것 보다 더 쉬운 경우

- 데이터 양이 너무 많을 때 효율적으로 계산하기 위해서

📍 경사하강법 과정

- 현재 지점의 기울기를 구하여 내가 이동해야 하는 방향을 정한다.(아래의 경사하강법 수식 유도 참고)

- 한 번 이동할 때마다 얼마나 이동할 것인지 step size(=learning rate)를 곱해서 그만큼 이동

- 최적의 해를 찾을 때까지 위의 과정을 반복

📍 경사 하강법의 수식 유도

- Gradient Descent란 함수의 기울기를 이용해 x의 값을 어디로 옮길 때 최솟값을 갖게 되는지 알아보는 방법.

- 기울기가 양수: x가 커질수록 y도 커짐.

- 기울기 음수: x가 커질수록 y는 작아짐.

→ 기울기가 양수일 땐 x가 작아지는 방향으로 옮기고, 기울기가 음수일 땐 y가 x가 커지는 방향으로 옮겨야한다.

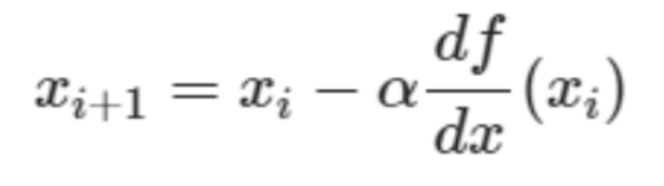

- 경사하강법 수식

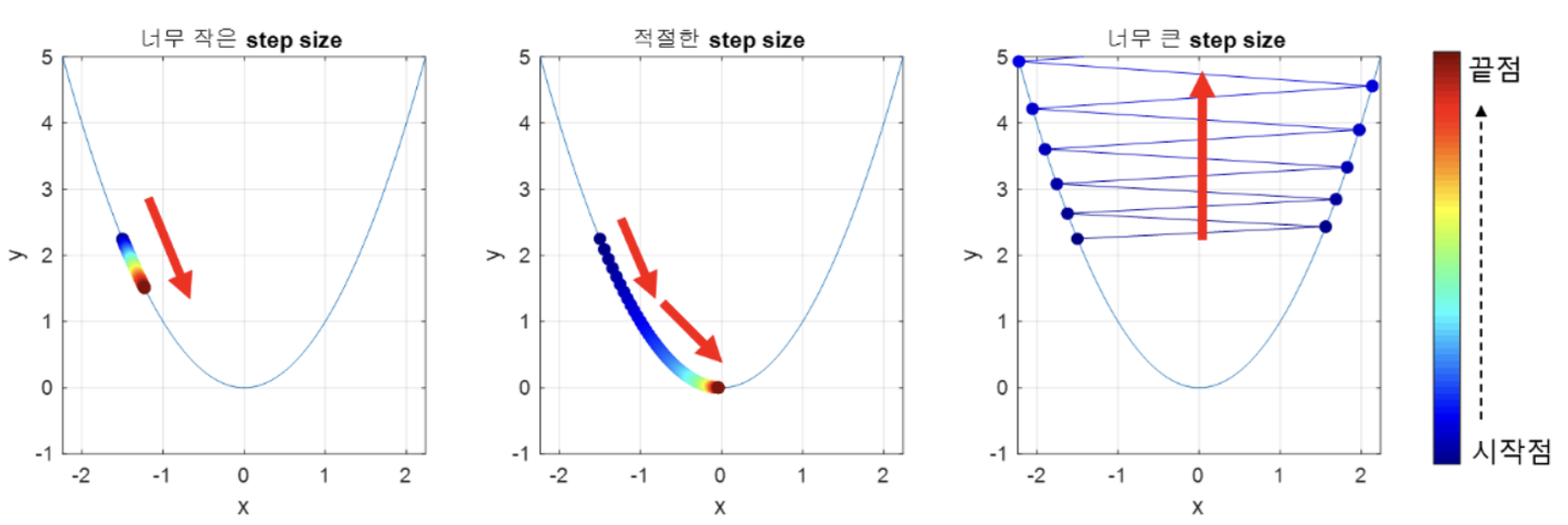

- α(=learning rate 라고도 함.)는 step size로 다음 step으로 이동할 때 얼마나 이동할지를 결정 짓는 수

- 적절한 크기의 step size를 정하는 것이 중요하다. step size가 크면 한 번 이동할 때 크게크게 이동하므로 빠르게 수렴 가능하지만, 너무 크게 설정해버리면 최솟값에 수렴하지 못하고 함수값이 계속 커지는 방향으로 최적화가 진행될 수 있다.

- step size가 너무 작으면 최솟값에 수렴하는데 너무 오랜 시간이 걸릴 수 있다.

→ 적절한 값의 α 즉, step size를 지정하는 것도 중요하다.

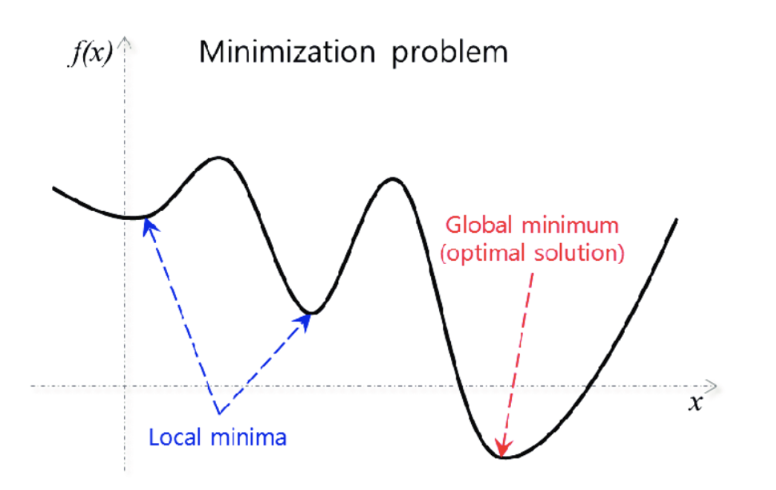

📍 경사 하강법의 한계 - Local Minimua

- global maximum까지 가지 못하고, local minima(국소해)에 빠지는 경우가 많다.

- 개선된 형태의 여러 가지 방법(momantum, stocastic gradient descent…) 이 존재.

🔗 정리

- 최적화란, 인공지능에서 신경망이 학습할 때 최적의 파라미터를 찾아가는 방식을 의미하고, 최적화 방법중에는 여러가지가 있지만, 오늘 배운 것은 경사 하강법이다. 이 경사 하강법은 기울기의 값을 이용해 손실 함수의 값을 줄여 가면서 최적의 파라미터를 찾아간다.

📚 References

https://dotiromoook.tistory.com/25

https://angeloyeo.github.io/2020/08/16/gradient_descent.html

🔗 다음 글

https://suucong.tistory.com/53

[AI] 경사하강법(feat: 최적화, 손실 함수) - 선형 회귀 분석(2) with Python(파이토치)

🔗 파이토치 2017년 초에 공개된 딥러닝 프레임워크 개발자들과 연구자들이 쉽게 GPU를 활용하여 인공 신경망 모델을 만들고 학습시킬 수 있게 도와줌 페이스북의 인공지능 연구팀(AI Research) 멤

suucong.tistory.com

'💻Programming > AI' 카테고리의 다른 글

[AI] 신경망 학습(밑바닥부터 시작하는 딥러닝) (0) 2023.12.18 [AI] 신경망과 활성화함수 / 행렬의 곱 / 신경망의 구현(밑바닥부터 시작하는 딥러닝) (1) 2023.12.17 [AI] 퍼셉트론과 퍼셉트론의 구현 / 퍼셉트론의 한계 (밑바닥부터 시작하는 딥러닝) (0) 2023.12.16 [AI] 경사하강법(feat: 최적화, 손실 함수) - 선형 회귀 분석(2) with Python(밑바닥부터 시작하는 딥러닝) (1) 2023.12.15 [AI] 퍼셉트론과 활성화 함수 (0) 2023.10.31